2024-07-23 14:48

2024-07-23 14:48

首个超越 GPT-4o 的开源模型Llama 3.1提前泄露!Hugging Face 紧急 404 | 附下载链接

坐拥最强大模型宝座两个月后,GPT-4o 的霸主级地位也不稳了。

在 5 月份的春季发布会上,OpenAI 发布了多模态大模型 GPT-4o ,再次夺回了最强大模型的宝座,当时业界的目光也投向了 Meta 的 Llama 3-405B,期待这款开源大模型能够撼动 GPT-4o 的统治地位。

前不久,外媒 The Information 放出消息称,Meta Llama 3 405B 将于当地时间 7 月 23 日正式发布,但没想到赶在发布的前一天,新模型 Llama 3.1 的关键「情报」已经不胫而走。

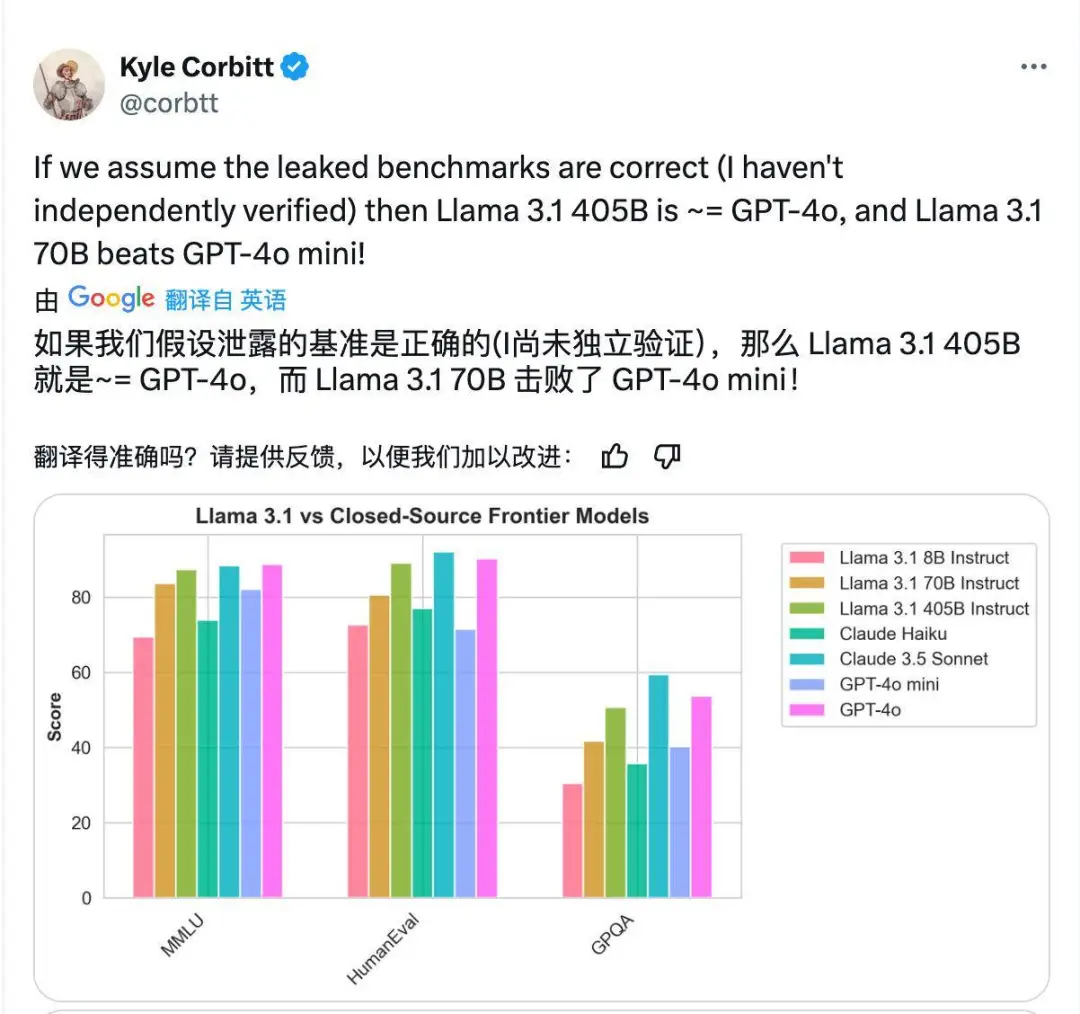

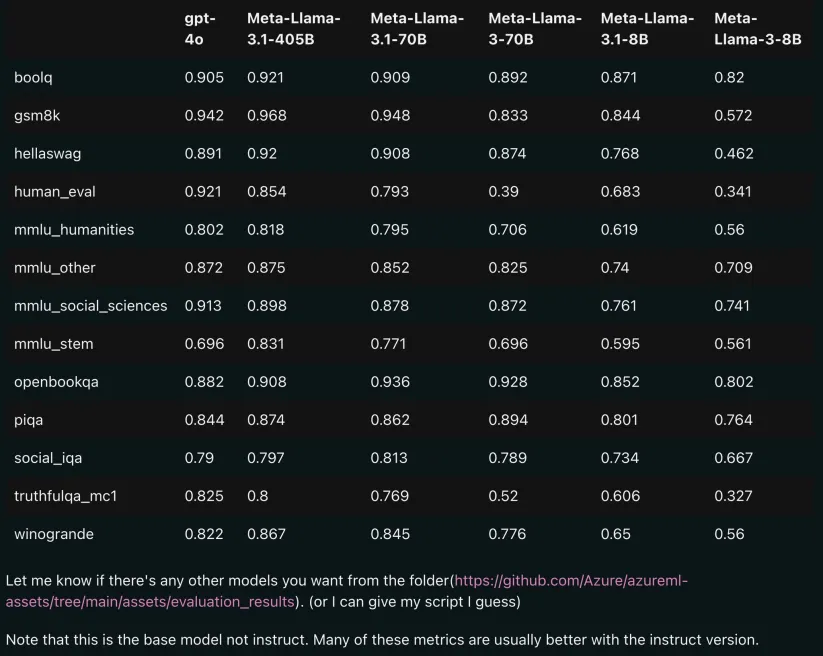

从 Llama 3.1 泄露的基准测试结果来看,Llama 3.1-405B 在 boolq、gsm8k、hellaswag 等多项基准测试得分均超越了 GPT-4o,甚至 70B 版本也能与 GPT-4o 互有胜负。

根据附带的说明,这还只是 base(基础)模型的评测结果,经过进一步指令微调,性能还有望提升。也就是说,如果泄露的数据靠谱,那么 Llama 3.1 或将上演一场开源逆袭最强闭源大模型的史诗级奇迹。

值得注意的是,泄露的 Meta Llama 3.1-8B 的纸面实力几乎接近 Meta-Llama-3-70B 版本,继上周 OpenAI 发布的 GPT-4o mini 之后,这或许又是一次小模型「以小胜大」的标志性案例。

根据泄漏的模型卡,Llama 3.1 的基本参数也相当亮眼。

Meta Llama 3.1 是一个经过预训练和指令微调的多语言大模型,拥有 8B、70B、405B 等不同版本。

支持英语、德语、法语、意大利语、葡萄牙语、印地语、西班牙语和泰语等多种语言。

模型的上下文长度为 128K,基于优化的 Transformer 架构,采用自回归语言模型。

Llama 3.1 使用了自定义训练库和 Meta 定制的 GPU 集群,使用来自公开来源的约 15 万亿个 token 数据进行了预训练,预训练数据的截止日期为 2023 年 12 月。

附上泄漏模型卡的地址:https://pastebin.com/9jGkYbXY

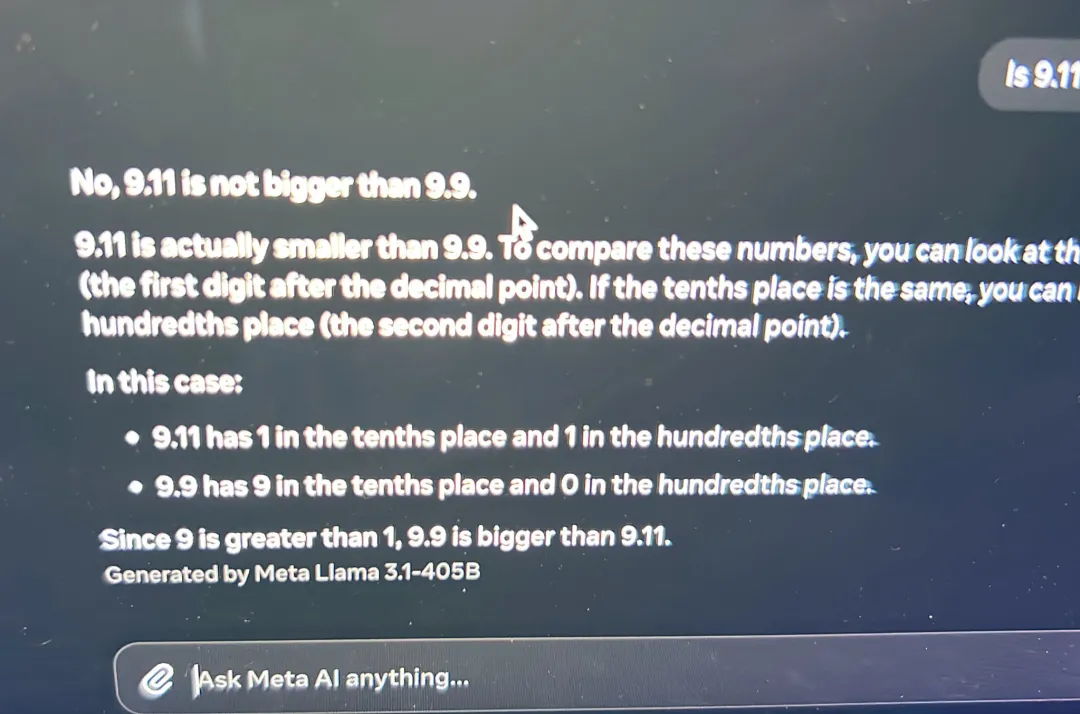

有意思的是,根据此前 Hugging Face 某个工程师泄露的信息,面对令众多大模型频繁翻车的「9.11 和 9.9 哪个大」难题,Llama 3.1-405B 也能游刃有余。

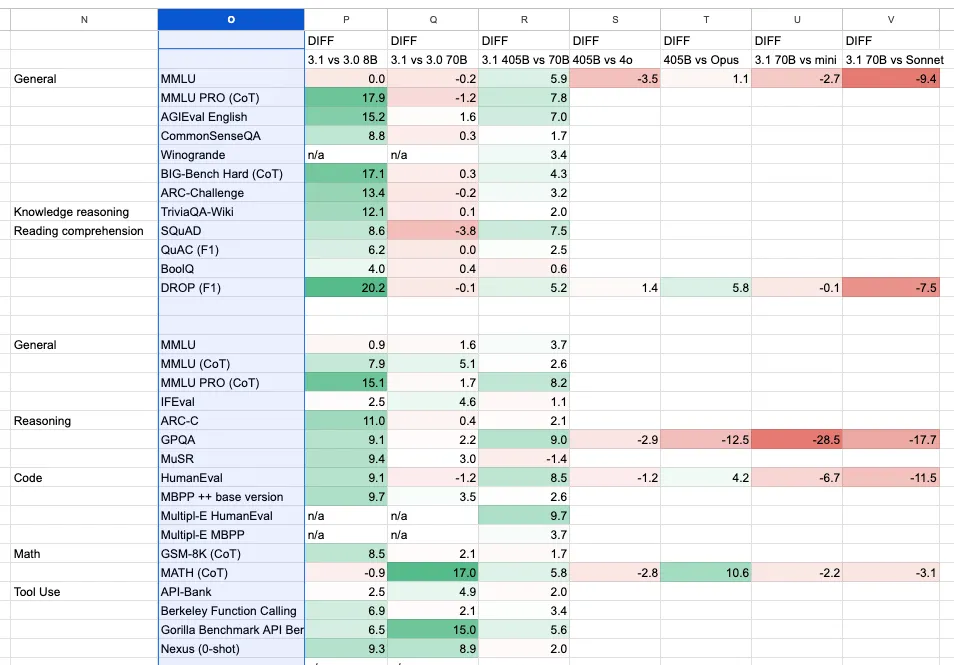

不过,先别急着高兴,Smol AI 团队整理目前泄露版表格中的数据并制作了可视化的对比表格,最终的结论是:

8B 模型的性能有了显著提升,各方面都有所改进;而 70B 模型略有提升。相比之下,405B 模型仍然不及旗舰模型。

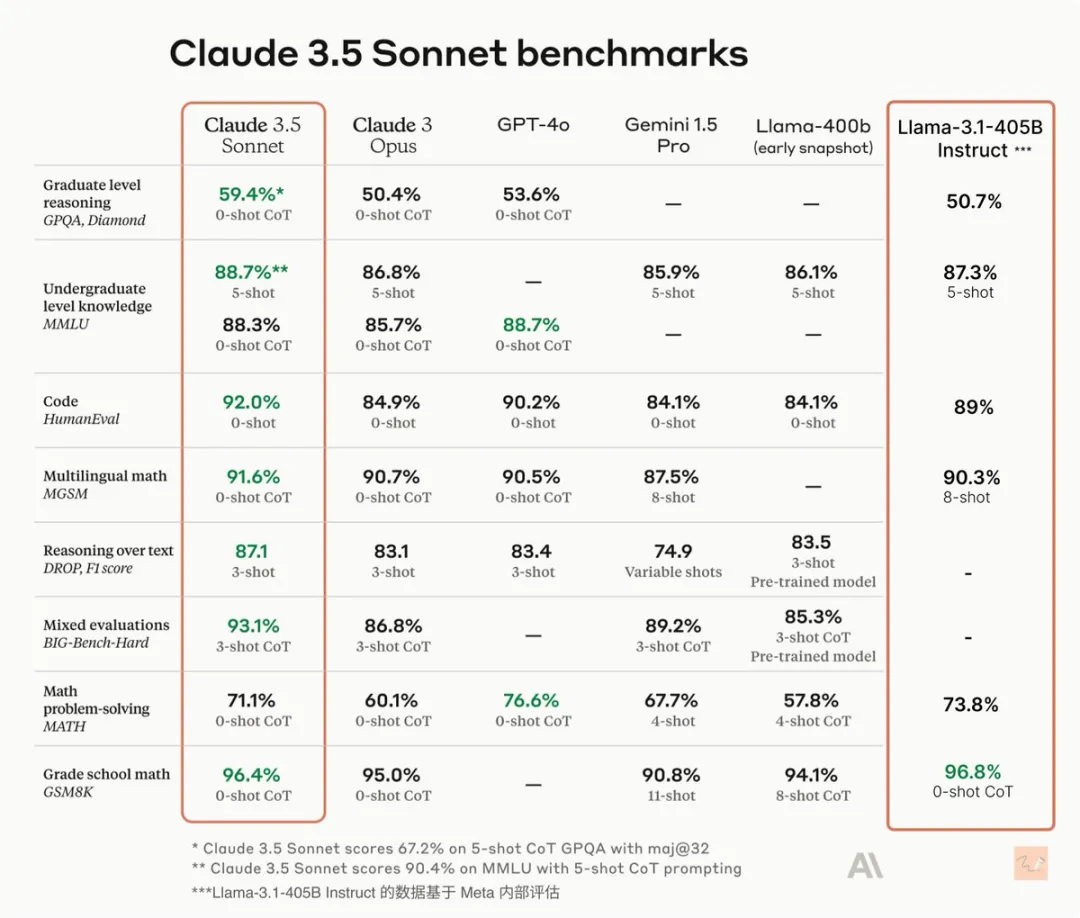

甚至有网友将 Llama 3.1-405B 与 Claude 3.5 Sonnet 的基准测试结果进行了对比,结果显示前者在代码生成和多语言数学方面等多个领域均逊于 Claude 3.5 Sonnet。

目前 Llama 3.1-405B Huggingface 的下载链接已经「404」了,而根据泄露的磁力链接,405B 模型权重预计将占用 820GB 硬盘空间,这对于普通独立开发者来说显然不太友好。

附上磁力链接地址:

Magnet:?xt=urn:btih:c0e342ae5677582f92c52d8019cc32e1f86f1d83&dn=miqu-2&tr=udp%3A%2F%

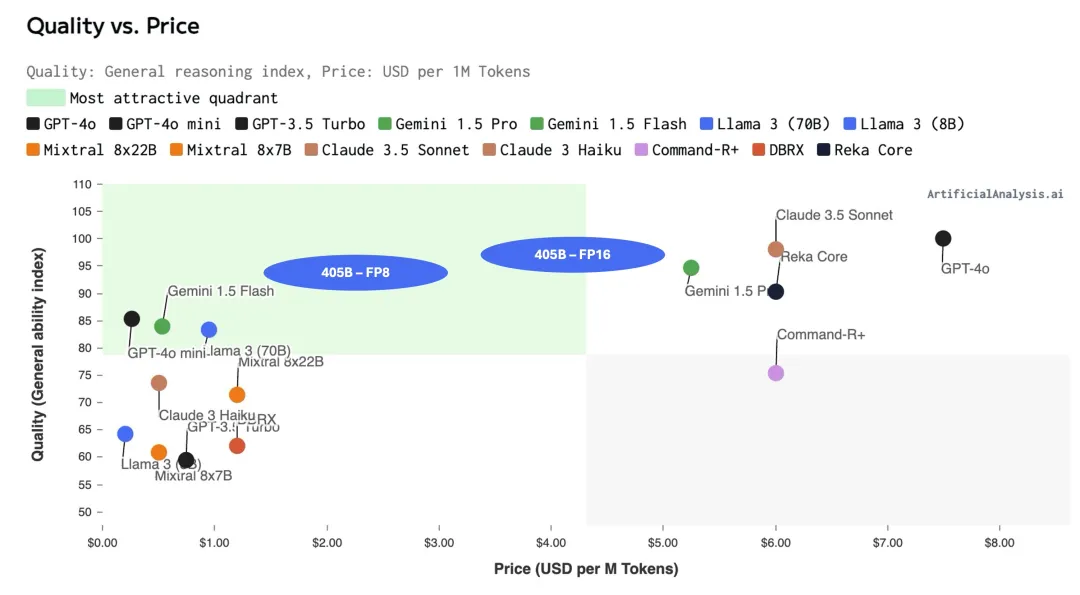

X 用户 @ArtificialAnlys 也预测了 Llama 3.1 405B 的质量与价格定位:

Llama 3.1 405B 将比当前的最先进模型(如 GPT-4o 和 Claude 3.5 Sonnet)便宜,但质量相当,从而在价格与质量的最优组合中占据新的位置。

服务商可能会针对不同的价格点提供 FP16 和 FP8 两种版本(FP16 需要 2 倍 DGX 系统,配备 8 个 H100s)。

405B 的 FP8 版本可能成为更重要的产品,有可能以每千次请求 1.50 至 3 美元的价格(混合比例 3:1)提供最先进水平的智能。

我们预测 FP16 的价格将在每千次请求 3.5 至 5 美元之间(混合比例 3:1),而 FP8 的价格将在每千次请求 1.5 至 3 美元之间。

而在 Llama 3.1 因泄露一事闹得沸沸扬扬的同期,擅长截胡对手的 OpenAI 却还沉浸在上周发布的 GPT-4o mini 的战果之中。同期,Sam Altman 还在 X 上发文称,

GPT-4 mini 于 4 天前推出,每天已经处理超过 200B tokens,很高兴听到人们有多喜欢新模型。

倘若最终发布的 Llama 3.1 真的能够夺走最强大模型的宝座,我们有理由期待,原本计划年底发布的 ChatGPT 下一个大版本是否会提前与我们见面。

并且,随着 2024 年的日历翻到下半年,AI 领域却呈现了小模型扎堆内卷的激烈态势。从此次泄露的信息来看,8B 和 70B 肉眼可见的进步也充分展示了小模型的巨大潜力。

更多具体的信息仍有待官方正式版本的发布,届时 APPSO 将第一时间为大家带来最新的消息。

本文转自Appso