2024-01-26 10:38

2024-01-26 10:38

谷歌发布今年首个AI视频全能模型Lumiere:迄今为止最强大,画质逆天,水时长第一,生成视频流畅一塌糊涂

岁末年初,“硅谷卷王”谷歌再次释出王炸新模型!这次聚焦AI视频生成赛道,要说今年不出一部AI大片我是不信的!

当地时间1月23日,谷歌发布名为Lumiere的新模型,采用了最先进的[时间↔空间]U-Net架构,可以生成高度一致性的完整视频片段。

废话不多说,直接上官方宣传片:

谷歌所谓的「U-Net架构」,简而言之就是在训练大模型的时候,在空间与时间两个维度同时采样,减少AI的“发散思考”,增强画面稳定性,能显著拉长生成视频的长度和质量。

这是谷歌AI团队历时7个月打磨的首个全能视频模型。

长期以来,AI视频生成一直存在诸多的缺陷:运动连贯性和一致性很低,卡成PPT,叠影重重等一系列问题。??

谷歌自研的UNet架构可以生成5秒的视频,比竞品Runway与Pika要多一两秒。

更为重要的是,谷歌视频模型可以生成80帧的片段!不仅画质好、质量高,而且时长更长。

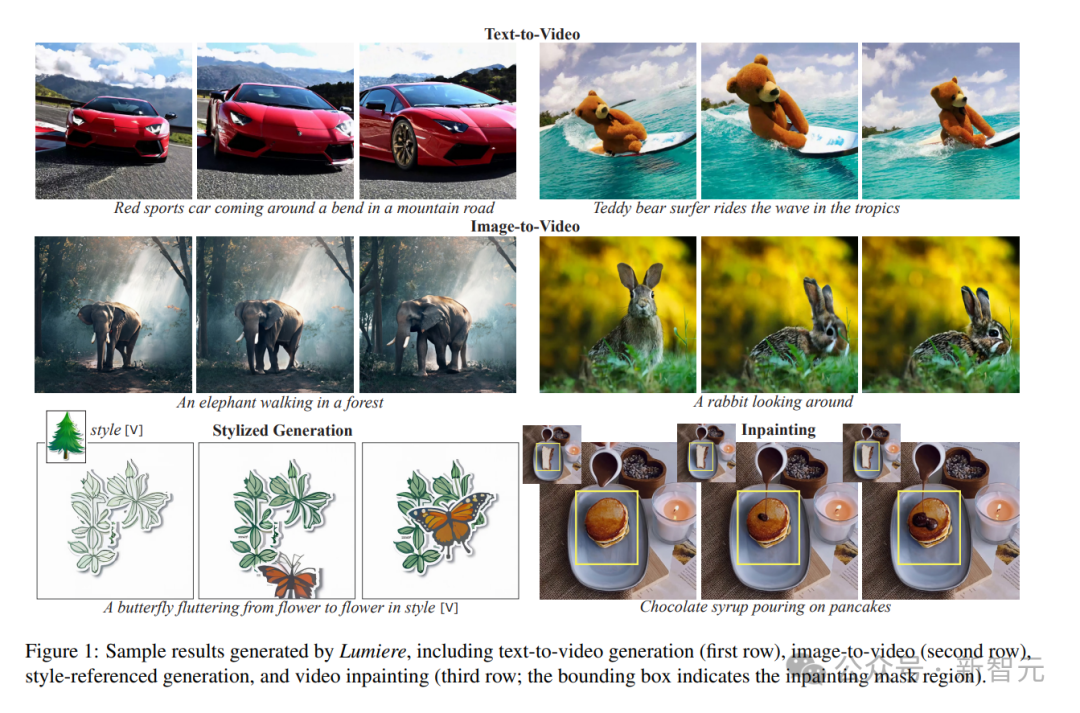

我们来看一些实际案例:

虽然还存在一些瑕疵,但作为首个落地模型已经相当不错了。

谷歌Lumiere视频模型不仅本领强,而且功能更加丰富,效果拔群!

这项功能可以让剪辑师快速针对视频画面当中的物体进行替换。

比如这个穿着绿色花点裙的女子,只需选中衣服的区域,输入几个简单的提示词文字,AI系统能瞬间将她的裙子换成红白条纹长裙、金色礼服。

正在晨跑的少女,让她长满鲜花,或者进行风格迁移,将其变成木砖风、折纸风、乐高风。

你甚至可以针对更小的对象进行修改和编辑。

比如,让?猫头鹰戴上眼镜。

除了修改画面的内容,甚至还可以针对损失局部画面的视频进行填充修补。

右下角的这个案例,充满想象力的AI系统画出了一块毫无破绽的慕斯蛋糕。

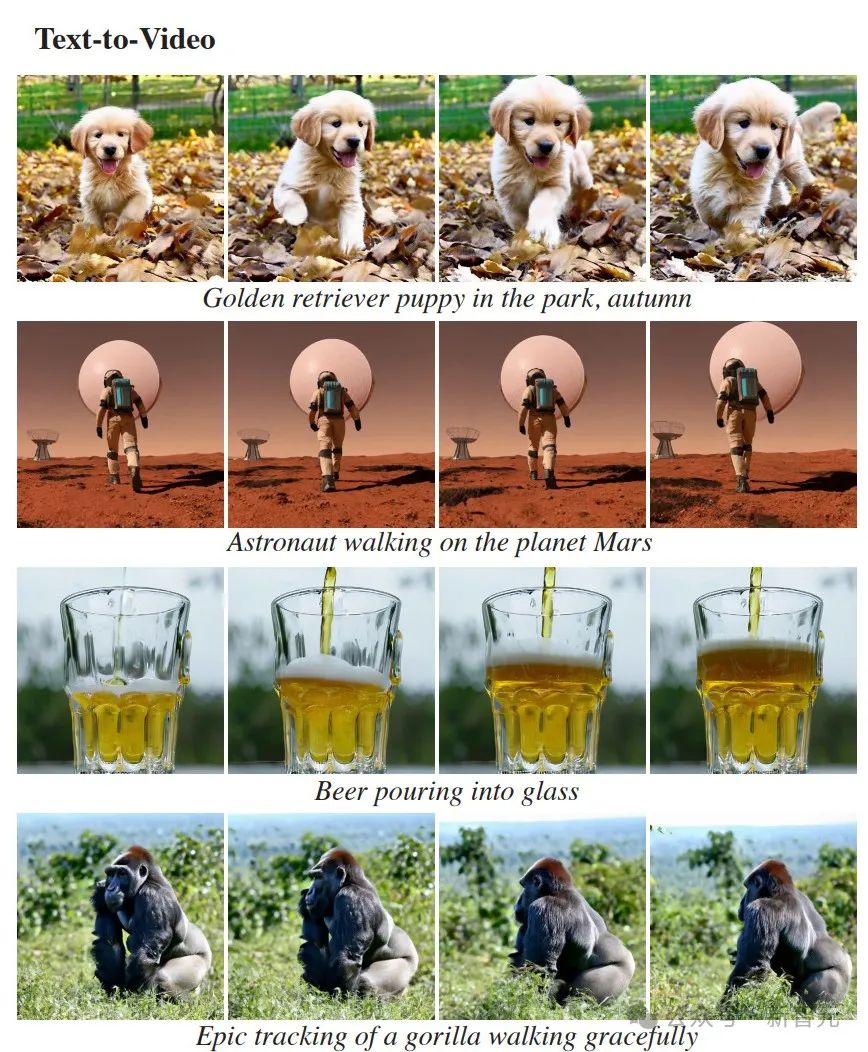

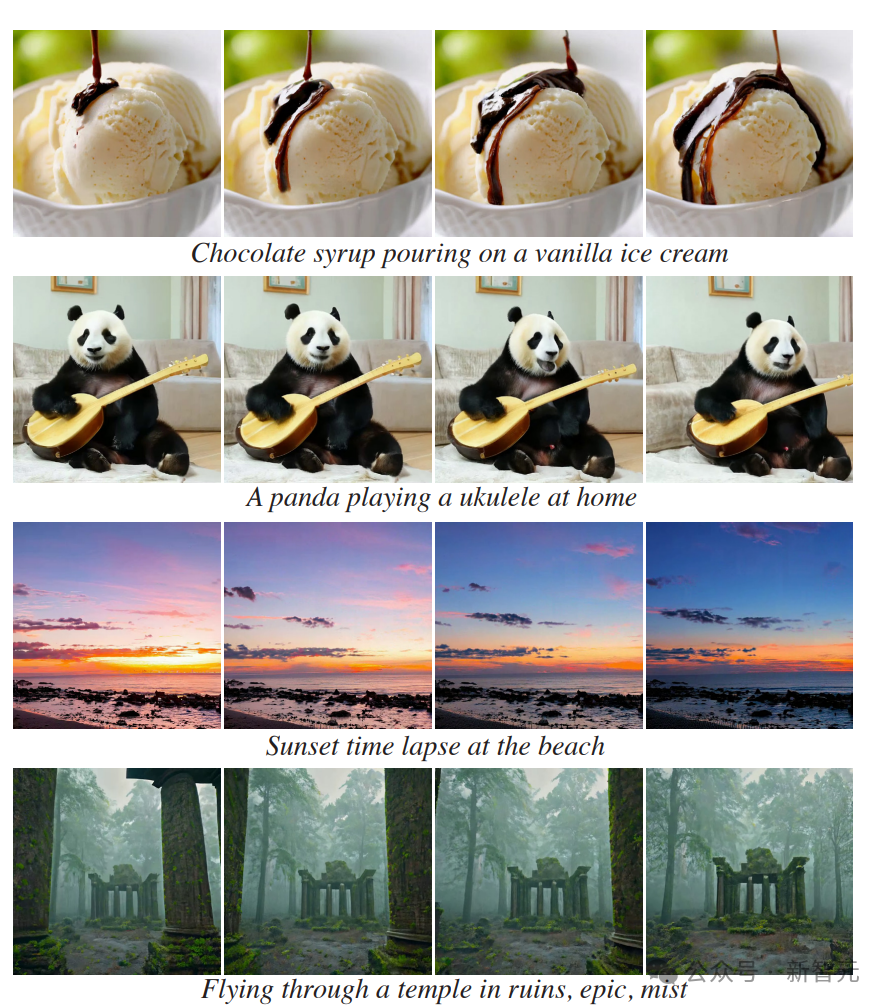

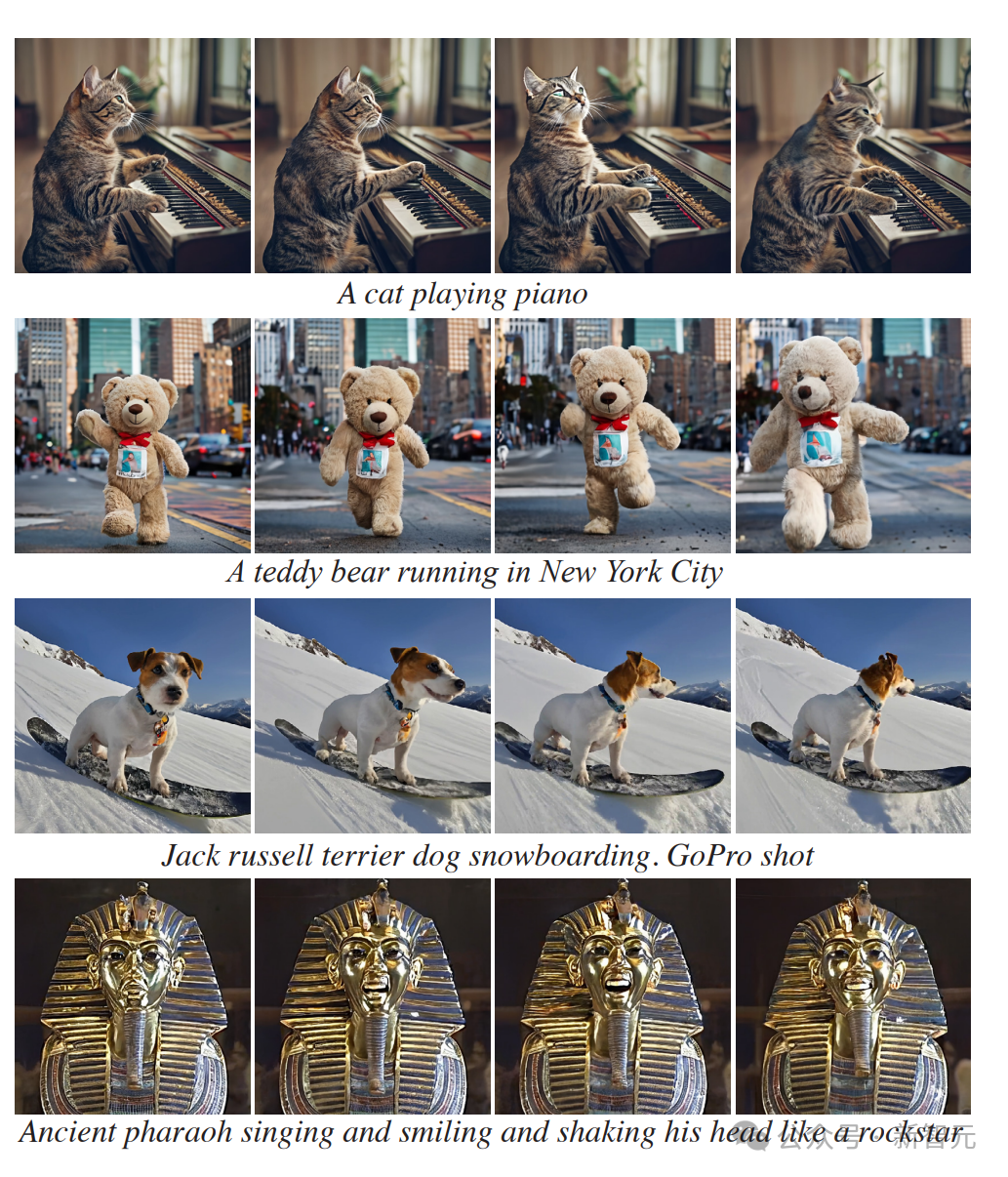

除了视频编辑功能,谷歌Lumiere自然也支持从文本生成视频片段。

画一个在火星基地周边漫步的宇航员。

画一只戴着太阳镜被车拉着走的小狗。

画一座废弃的庙宇,在遗迹中穿行。

谷歌Lumiere另外一个非常好用的功能,便是将静态图像转换为动态视频。

输入提示词「姑娘微笑和眨眼」?,戴珍珠耳环的少女从名画中走出,咧嘴笑了起来。

梵高《星空》,以令人不可思议的方式流动起来。

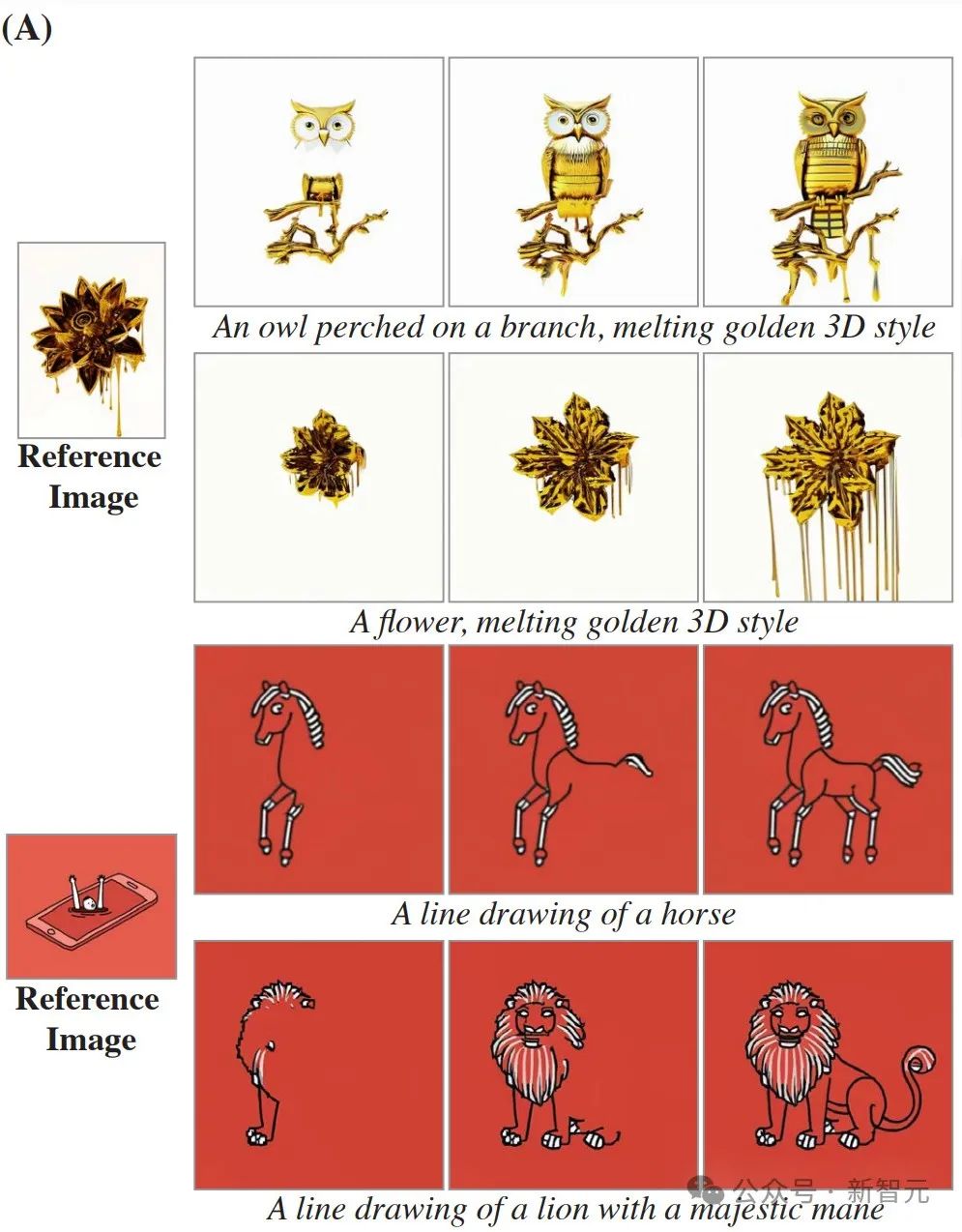

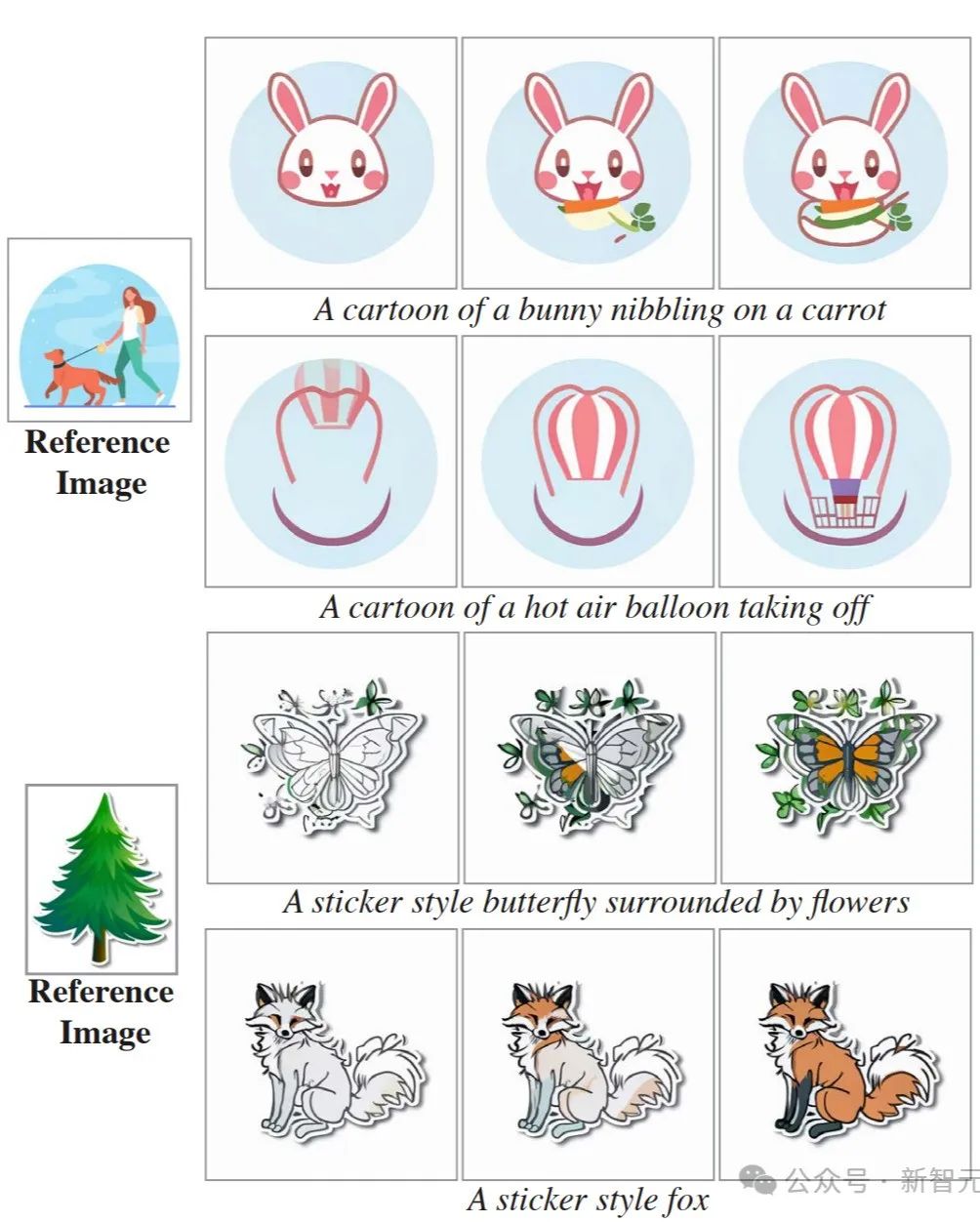

除了一般的“图生视频”,谷歌Lumiere模型还能根据参考图生成特定风格的动态艺术视频。

比如,传一张夜光蘑菇图?,生成各种散发荧光的动物。

再看几个别的案例,生成的视频风格复刻得非常精准。

这对于那些技艺较浅的普通视频作者真是降维打击。

看到这四个字,熟悉AI视频创作的家人们想必马上联想到Runway Gen-2模型正在内测的相似功能。

?相关阅读:

AI视频可控性里程碑:Runway Gen-2上线「多重运动笔刷」大量实战案例:一键可让五个物体以不同形式运动

AI视频可控性里程碑更新:1月18日,Runway上线了多重运动笔刷,这个功能可以单独控制最多五个笔刷选定的区域。让我们看看那些优秀应用案例。

Runway发布全新多重运动笔刷技能:AI视频“图生视频”可控性的高能进化!轻松复刻《黑客帝国》子弹瞬间

AI视频可控性高能进化!1月18日,AI视频创作工具开发商Runway宣布重磅更新:全新升级的运动笔刷,5个笔刷控制5个物体运动,多重运动笔刷上线。

谷歌也提供了类似的能力,起名为Cinemagraphs(静帧动画)。吐槽一句,谷歌给产品起的名字总是那么地反直觉与难记…

随意选中静态图当中的某个对象,让它立即动起来。比如这团火焰,一键让它熊熊燃烧。?

选中图中的烟,火车轰隆隆地发动。

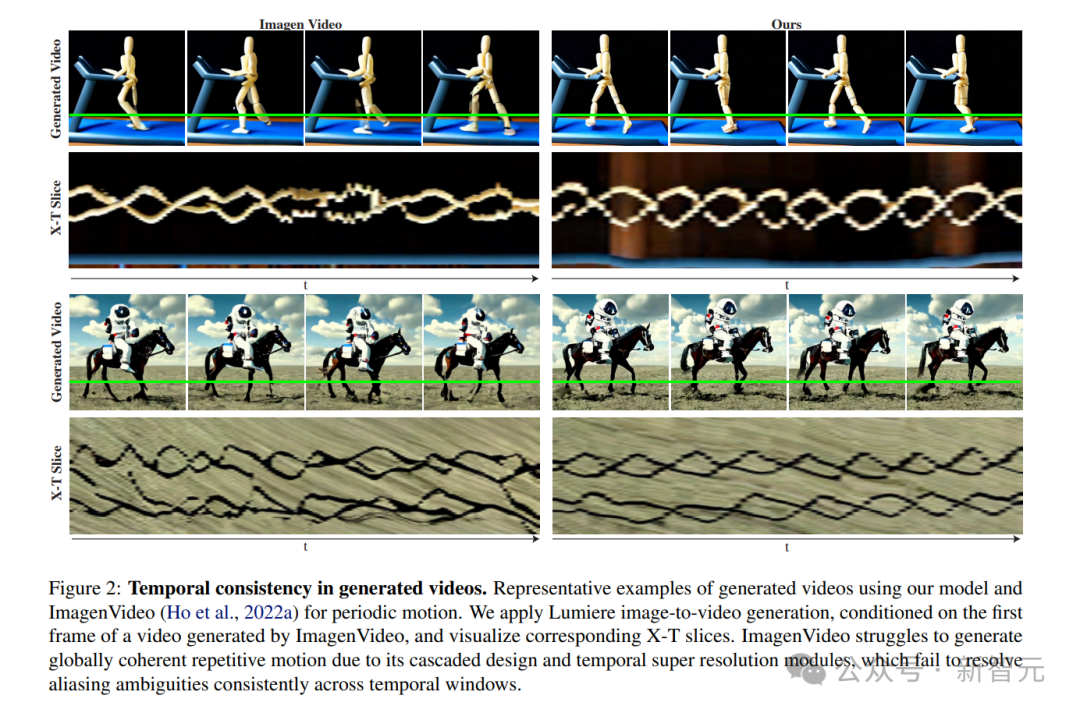

所谓的U-Net架构,通俗简单地形容,就是大模型通过在同一时间与空间下的采样,学习物体运动的逻辑规律,并压缩模型输出的数据量,从而最小化执行大部分的计算。

在过去,AI视频生成的本质是将一堆AI脑补的图像进行滚动播放,谷歌的这个新架构则是让AI先掌握物体的运动逻辑。

采用这种方法,能够以16FPS生成80帧的连贯动画,比绝大多数其他视频模型都要好。跟之前的工作相比,产生了更多的全局连贯运动。

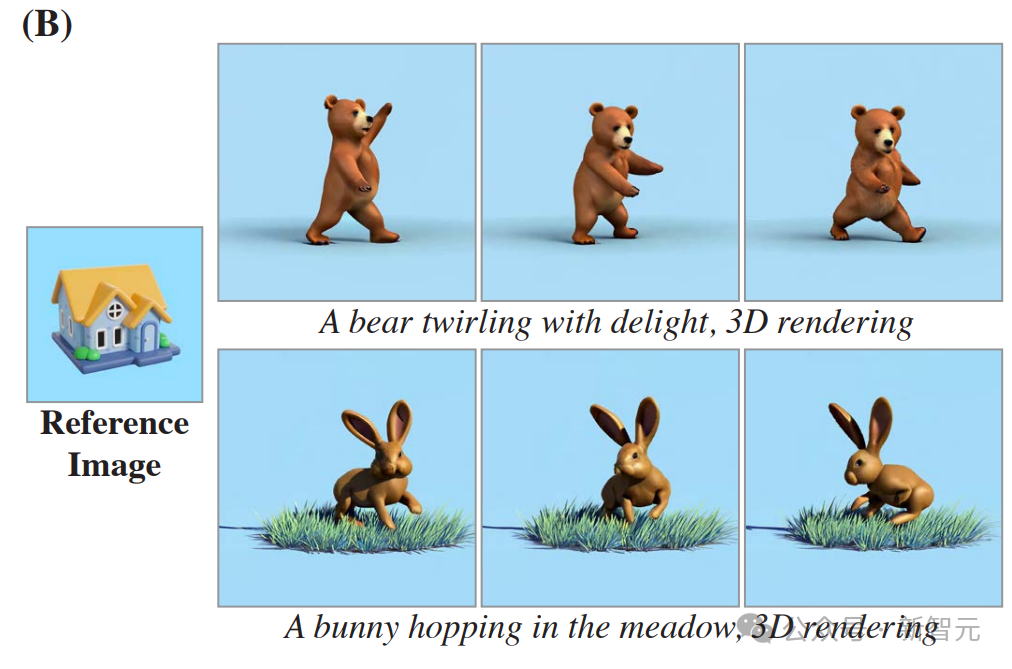

以下是“文生视频”和“图生视频”的案例拆解。

首先来看文本生成视频,最左边的这一帧画面,是作为先决条件生成,提供给模型参考生成下一帧画面的图像。

接着来看图像生成视频的拆解,逻辑与“文生视频”很相似,只是利用本地的现成参考图来替代AI生图而已。

以下是风格化生成的案例拆解。

从左到右,谷歌Lumiere模型能够借着参考图创作相似拟态的静帧图像。

有了第一张初始图像后,就很容易生成一段有运动规律的视频了。

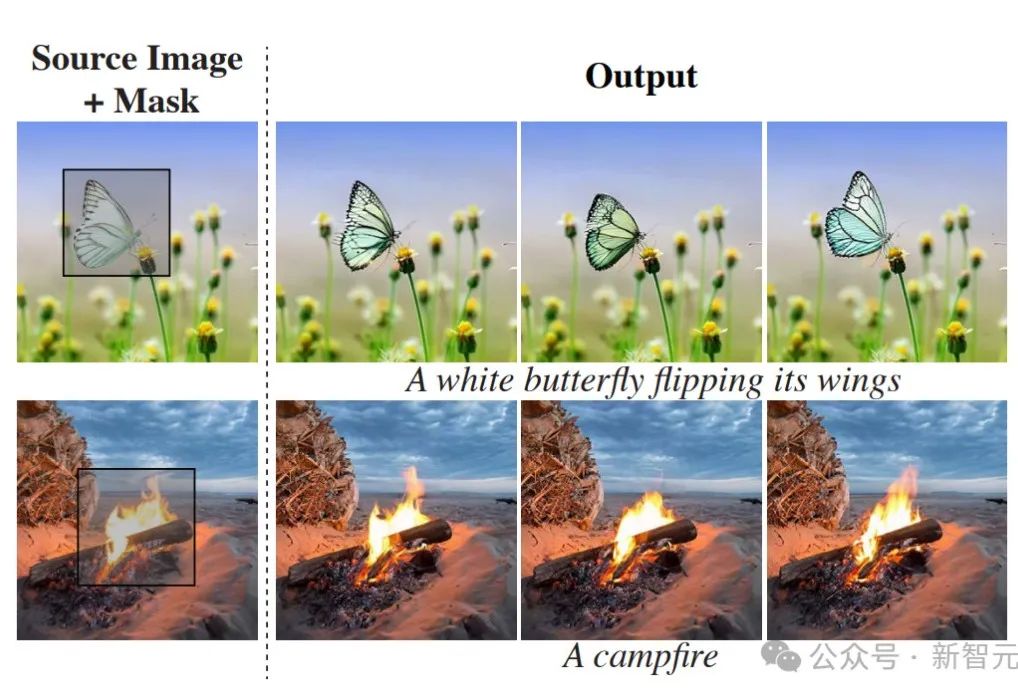

至于说视频修复与画面对象替换,二者的逻辑大差不差。

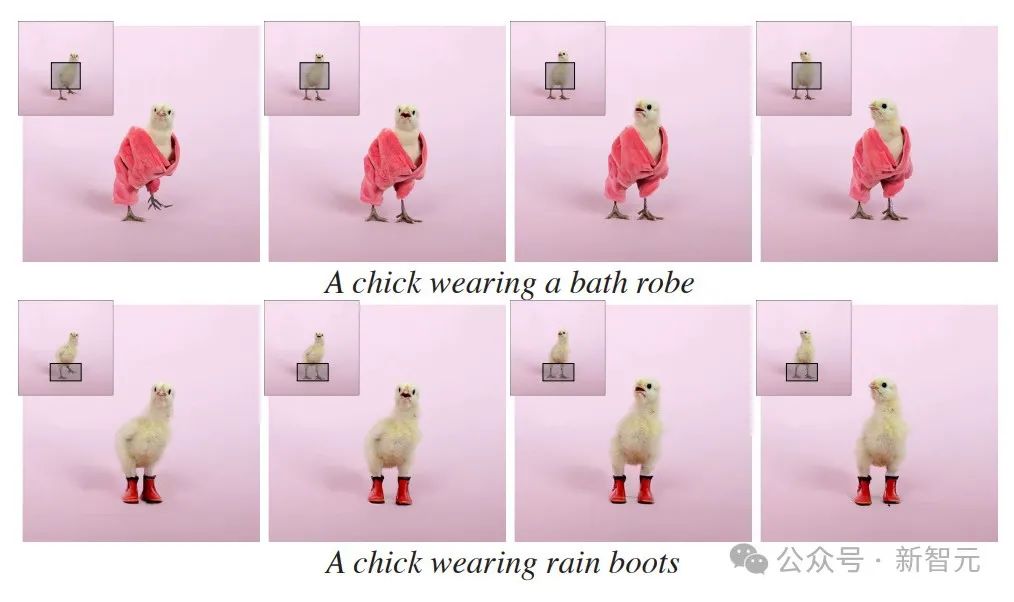

谷歌Lumiere先对框选需要修改的视频局部进行掩码,然后根据提示词创建这部分掩码区域的动画,其余部分则保持不变。

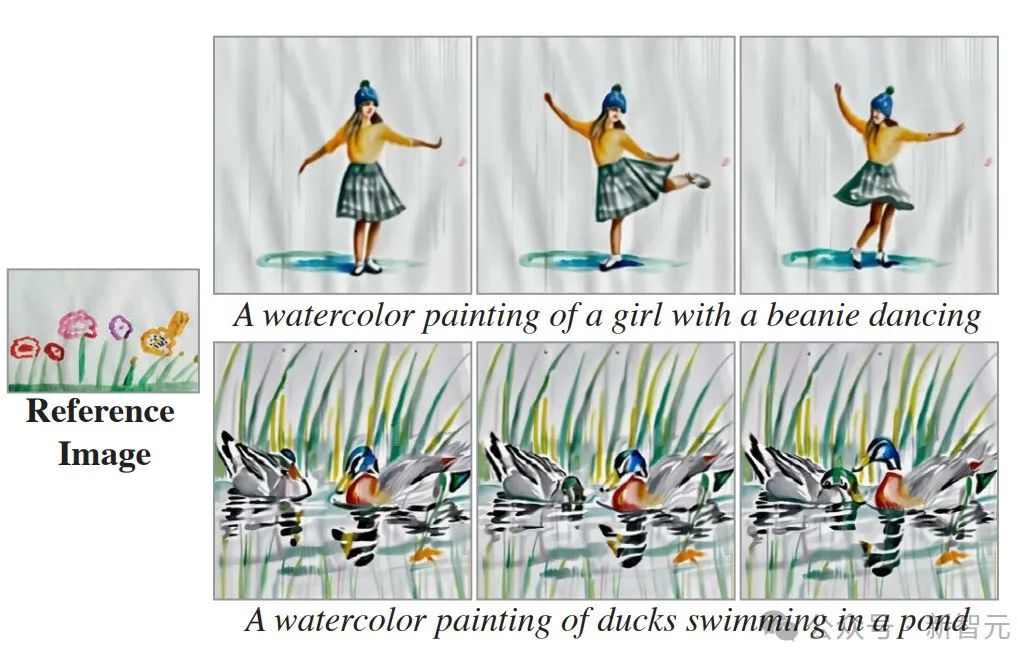

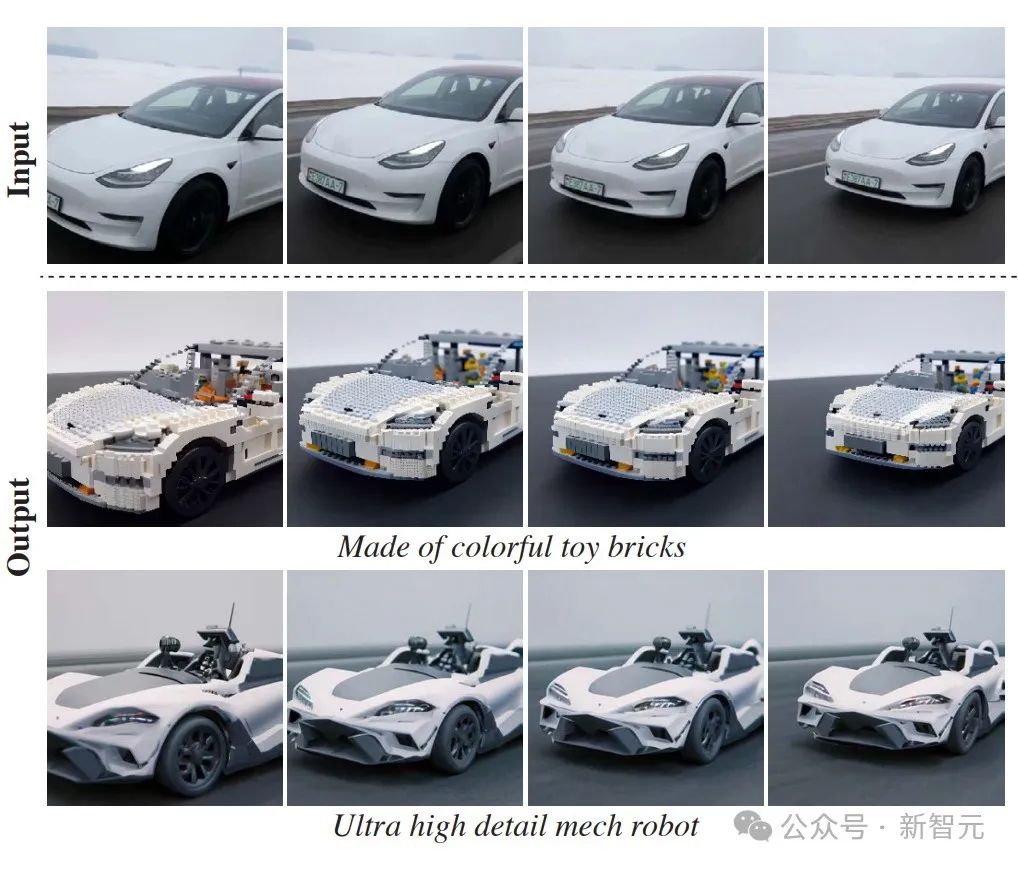

最后来看下视频风格迁移。

谷歌Lumiere模型将第一排的原始视频拆解成一帧一帧的静态画面,然后根据提示词创建对应画面的生成图像,从而实现高度一致的视频风格化。

第二、第三排是风格转化之后的两种不同的感觉。

这种技法常常会用于大量的二创题材。

生成质量评估

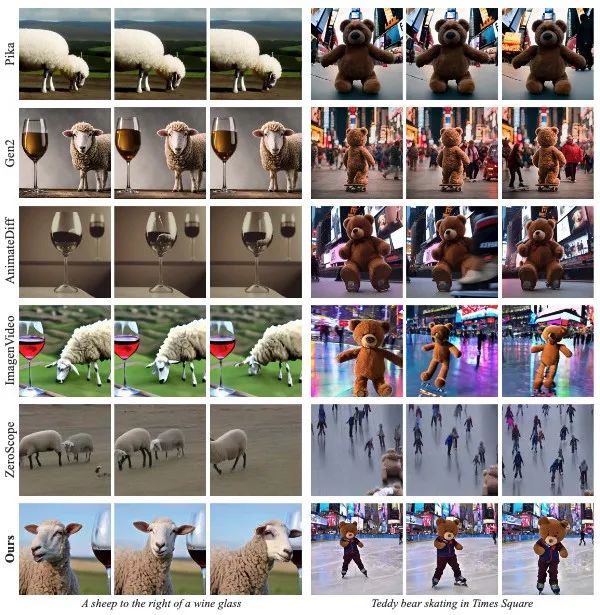

谷歌的研究人员选择了当前赛道上最负盛名的五款视频模型,其中不乏Runway、Pika Labs、阿里等名企。

研究人员观察到,业内翘楚的Runway Gen-2和Pika输出画质特别高,但是运动幅度较小。

ImagenVideo产生合理的运动量,但整体画质较低;AnimateDiff和ZeroScope表现出明显的运动幅度,但也容易出现重影。

此外,它们生成的片段普遍较短,最多也不会超过4秒。

相比之下,谷歌Lumiere可以生成5秒高质量、一致性稳定的短视频,具有较为突出的优势。

生成精度评估

除了对比画质以外,研究人员还针对提示词复现进行了横评。

通过这张表可以看到,分数越低(趋于0)表明越靠近提示词的表述。

在“王婆卖瓜”的研究里边,谷歌Lumiere展现了实力。必须强调的是,这项指标并不能准确地反映人类的主观评判。

用户主观喜好研究

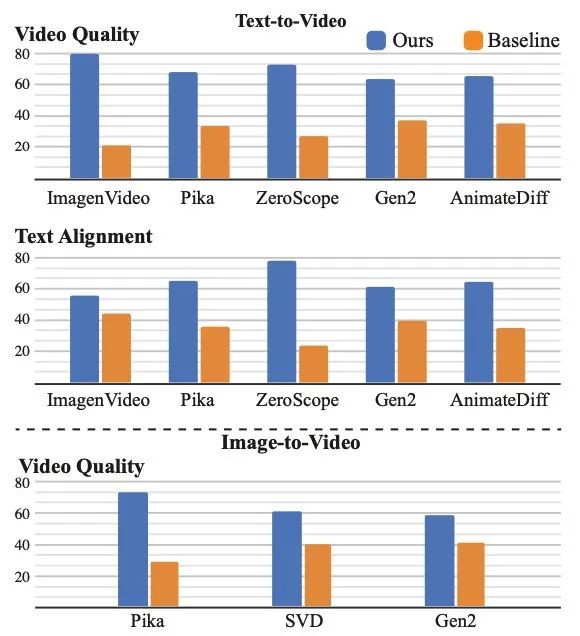

于是,最后研究人员引入了用户评价来进行盲测。

研究人员向测试参与者随机展示由谷歌Lumiere与竞品模型生成的视频片段,参与者被要求选出他们认为更好的那则视频并进行打分。

本项研究大约收集了400个用户样本,??成绩如下:

很显然,蓝色的柱状得票率更高,谷歌Lumiere模型生成的内容似乎更受用户青睐。

总而言之,谷歌Lumiere视频模型就是「大获全胜」!

如果你对于这款新模型感兴趣的话,可以访问他们的网页,据说后续还会开源唷~~

项目主页:

近期文章

更多