2023这个大模型爆发的元年即将过去,展望未来,比尔盖茨,李飞飞,吴恩达等人对2024年人工智能的发展作出了自己的预测。

2023-12-20 14:09

2023-12-20 14:09

2024年的AI行业会怎么发展?比尔盖茨、李飞飞、吴恩达等大佬预测AI十大新趋势:GPU持续短缺、AI智慧体年内大爆发

摘要

2023这个大模型爆发的元年即将过去,展望未来,比尔盖茨,李飞飞,吴恩达等人对2024年人工智能的发展作出了自己的预测。

2023,可以说是人工智能的春天。在过去的一年里,ChatGPT成为家喻户晓的名字,

这一年中,AI和AI公司的各种变革,让我们震惊,也成为我们茶余饭后的瓜果;这一年中,生成式AI取得了重大进展,使得人工智能初创公司吸引了大量资金。

人工智能领域的大佬们开始讨论AGI的可能性,政策制定者开始认真对待人工智能监管。但在人工智能和科技行业们的领袖眼中,AI浪潮可能才刚刚起步。之后的每一年,可能都是浪潮最汹涌澎湃的一年。

比尔盖茨、李飞飞、吴恩达等人,都在最近对未来AI的发展趋势谈了自己的看法。他们都不约而同地谈到了期待更大的多模态模型、更令人兴奋的新功能,以及围绕我们如何使用和监管这项技术的更多对话。

比尔盖茨在自己的官方博客上发表了一篇万字长文,将他眼里的2023年描绘成了一个新时代的全新开端。

这篇博客依然还是从他在盖茨基金会为切入,谈到了世界范围内已经出现或者将会出现哪些影响深远的变化。

针对AI技术的发展,盖茨说:

如果我必须做出预测,那在像美国这样的高收入国家,我猜我们距离普通大众广泛地使用人工智能还有18到24个月的时间。在非洲国家,我预计在三年左右的时间里会看到类似的使用水平。这其中仍然存在差距,但它比我们在其他创新中看到的滞后时间要短得多。

比尔盖茨认为,AI作为目前地球范围内影响最深远地创新技术,将会在3年内彻底席卷全球。

盖茨在博文中表示,2023年是他第一次在工作中出于「严肃的原因」使用人工智能。

与前几年相比,世界对AI能够自己完成哪些工作以及「充当哪些工作的辅助工具」有了更好的认识。

但对于大部分人来说,要让AI在工作场景中充分发挥作用还有一定距离。

基于他自己获得的数据和观察体验,他表示行业应该吸取的一个最重要的教训是:产品必须适合使用它的人。

他举了一个简单的例子,巴基斯坦人通常互相发送语音留言,而不是发送短信或电子邮件。因此,创建一个依赖语音命令而不是输入长查询的应用程序是有意义的。

从他本人最关心的角度,盖茨提出了5个问题,希望工智能可以在相关领域发挥巨大作用:

-人工智能可以对抗抗生素耐药性吗?

-人工智能能否为每个学生创造出个性化的导师?

-人工智能可以帮助治疗高危妊娠吗?

-人工智能可以帮助人们评估感染艾滋病毒的风险吗?

-人工智能能否让每个医务工作者更轻松地获取医疗信息?

如果我们现在做出明智的投资,人工智能可以让世界变得更加公平。它可以减少甚至消除富裕世界获得创新与贫穷世界获得创新之间的滞后时间。

吴恩达最近在接受英国《金融时报》采访时表示,“人工智能末日论”非常荒谬,AI监管将会阻碍AI技术本身的发展。

在他看来,目前人工智能的相关监管措施对防止某些问题产生几乎没有任何效果。这样无效的监管除了会阻碍技术的进步,不会有任何正面的受益。所以在他看来,与其做低质量的监管,不如不要监管。

他举了最近美国政府让大科技公司自我承诺对AI生成内容自行添加「水印」,来应对虚假信息等问题为例。

在他看来,自从白宫自愿承诺以来,一些公司反而不再对文本内容加水印。因此,他认为自愿承诺方法作为一种监管方法是失败的。

而另一方面,如果监管机构将这种无效的监管移植到诸如「监管开源AI」等问题上,很有可能会完全扼杀开源的发展并且造成大型科技公司的垄断。

那如果AI获得的监管水平是目前的样子,那确实没有监管的意义。

吴恩达重申,实际上,他希望政府能够亲自动手并制定良好的监管规定,而不是现在看到的糟糕的监管提案。所以他并不主张放手不管。但在糟糕的监管和没有监管之间,他宁愿没有监管。

吴恩达还在访谈中谈到,现在大语言模型已经了具备了世界模型的雏形。

「我所看到的科学证据来看,人工智能模型确实可以构建世界模型。因此,如果人工智能有一个世界模型,那么我倾向于相信它确实理解世界。但这是我自己对理解一词含义的理解。

如果你有一个世界模型,那么你就会了解世界如何运作,并可以预测它在不同场景下如何演变。有科学证据表明,LLM在接受大量数据训练后,确实可以建立一个世界模型。」

知识工作者的挑战

斯坦福数字经济实验室主任Erik Brynjolfsson等人预计,人工智能公司将能够提供真正影响生产力的产品。

而知识工作者将受到前所未有的影响,比如创意工作者、律师、金融学教授的工作将发生很大变化。

在过去的30年中,这些人基本没有受到计算机革命的影响。

我们应该接受人工智能带来的改变,让我们的工作变得更好,让我们能做以前做不到的新事情。

虚假信息扩散

斯坦福大学工程学院教授James Landay等人认为,我们将看到新的大型多模态模型,特别是在视频生成方面。

所以我们还必须对严重的深度伪造更加警惕,

作为消费者需要意识到这一点,作为民众也需要意识到这一点。

我们将看到OpenAI等公司和更多的初创公司,发布下一个更大的模型。

我们仍然会看到很多关于「这是AGI吗?什么是AGI?」的讨论,——但我们不必担心人工智能会接管世界,这都是炒作。

我们真正应该担心的是现在正在发生的危害——虚假信息和深度伪造。

GPU短缺

斯坦福大学教授Russ Altman等人对于全球性的GPU短缺表示担心。

大公司们都在尝试将AI功能引入内部,而英伟达等GPU制造商已经满负荷运转。

GPU,或者说AI的算力,代表了新的时代的竞争力,对于公司甚至是国家来说都是如此。

对于GPU的争夺也会给创新者带来巨大的压力,他们需要提出更便宜、更易于制造和使用的硬件解决方案。

斯坦福大学和许多其他科研机构,都在研究当前GPU的低功耗替代方案。

想要达到大规模商用,这项工作还有很长的路要走,但为了实现人工智能技术的民主化,我们必须继续前进。

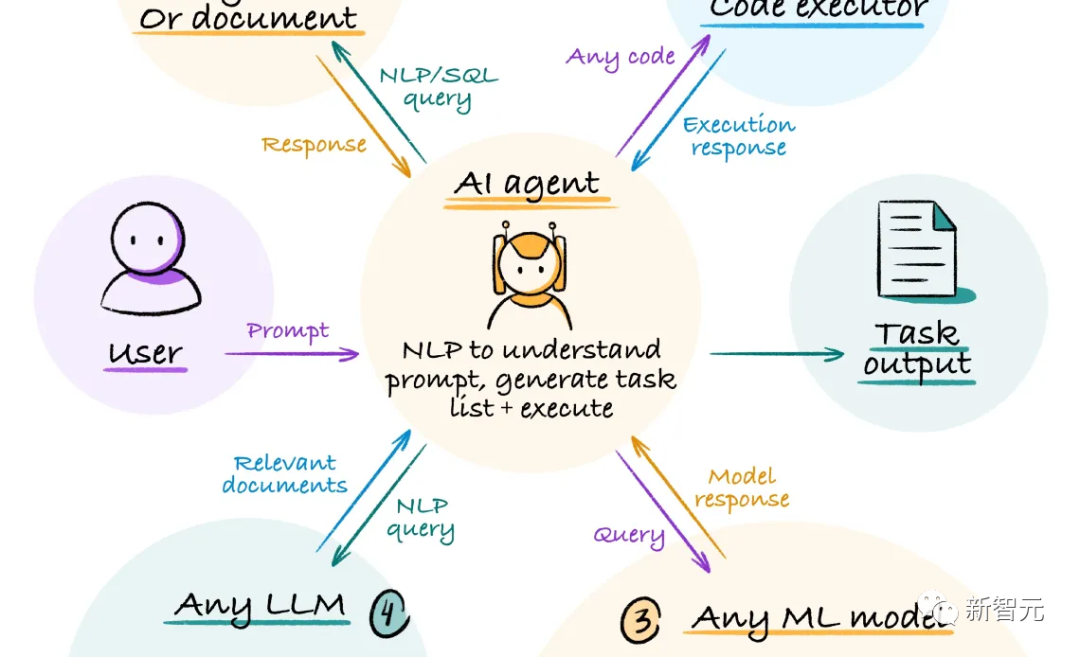

更有用的AI Agent

斯坦福大学杰出教育研究员Peter Norvig认为,未来的一年代理(Agent)将会兴起,AI将能够连接到其他服务,并解决实际的问题。

2023年是能够与AI聊天的一年,人们与AI的关系只是通过输入和输出来进行的互动。

而到了2024年,我们将看到代理为人类完成工作的能力,——进行预订、计划旅行等等。

此外,我们将朝着多媒体迈进。

到目前为止,人们已经非常关注语言模型,然后是图像模型。之后,我们也将有足够的处理能力来发展视频模型,——这将非常有趣。

我们现在正在训练的东西都是非常有目的性的,——人们在页面和段落中写下自己认为有趣和重要的事情;人们利用相机纪录某些正在发生的事。

但是对于视频来说,有些摄像机可以24小时运行,它们捕捉发生的事情,没有任何过滤,没有任何目的性的筛选。

——人工智能模型以前没有这种数据,这将使模型对一切有更好的理解。

对AI监管的希望

斯坦福大学HAI联合主任李飞飞表示,2024年,人工智能政策将值得关注。

我们的政策应该保障学生和研究人员能够获得AI资源、数据和工具,以此来提供更多人工智能开发的机会。

另外,我们需要安全、可靠和可信赖地开发和使用人工智能,

所以,政策除了要致力于培养充满活力的人工智能生态系统,还应致力于利用和管理人工智能技术。

我们需要相关的立法和行政命令,相关的公共部门也应该获得更多投资。

提出问题,给出对策

斯坦福大学HAI高级研究员Ge Wang希望,我们将有足够的资金来研究,生活、社区、教育和社会能够从人工智能中得到什么。

越来越多的这种生成式人工智能技术将嵌入到我们的工作、娱乐和交流中。

我们需要给自己留出时间和空间,来思考什么是允许的,以及我们应该在哪些方面做出限制。

早在今年2月,学术期刊出版商Springer Publishing就发表了一份声明,表示可以在起草文章时使用大型语言模型,但不允许在任何出版物上作为合著者。他们引用的理由是问责制,这一点非常重要。

——认真地把一些东西摆在那里,阐述理由是什么,并表示这就是现在的理解方式,将来可能会在政策中加入更多改进。

机构和组织必须有这样的视角,并努力在2024年落实在纸上。

公司将面临复杂的法规

斯坦福大学 HAI 隐私和数据政策研究员Jennifer King表示,除了今年欧盟的《人工智能法案》,到2024年年中,加利福尼亚州和科罗拉多州将通过法规,解决消费者隐私背景下的自动决策问题。

虽然这些法规仅限于,对个人个人信息进行训练或收集的人工智能系统,但两者都为消费者提供了选择,即是否允许某些系统使用AI以及个人信息。

公司将不得不开始思考,当客户行使他们的权利时(特别是集体行使权利时),将意味着什么。

比如一家使用人工智能来协助招聘流程的大公司,如果数百名应聘者都拒绝使用AI,那要怎么办?必须人工审查这些简历吗?这又有什么不同?人类能够做的更好吗?——我们才刚刚开始解决这些问题。

近期文章

更多