2023-12-07 08:59

2023-12-07 08:59

谷歌发布年度最强的大语言模型Gemini丨微软Copilot全家桶升级GPT-4 Turbo丨微软Meta今年买走最多英伟达GPU

AI奇点网2023年12月7日报道丨AI资讯早报

当地时间12月6日周三,谷歌正式向公众发布新一代大语言模型Gemini,号称谷歌迄今为止“最大、也最全能的AI模型”,有高级推理能力,回答难题时“考虑得更仔细”。有别于其他公司LLM竞品的是,谷歌强调Gemeni是最灵活的模型,因为它用不同大小的版本,可以适用于各种生成式AI应用。

点击下方卡片了解大模型产品信息:

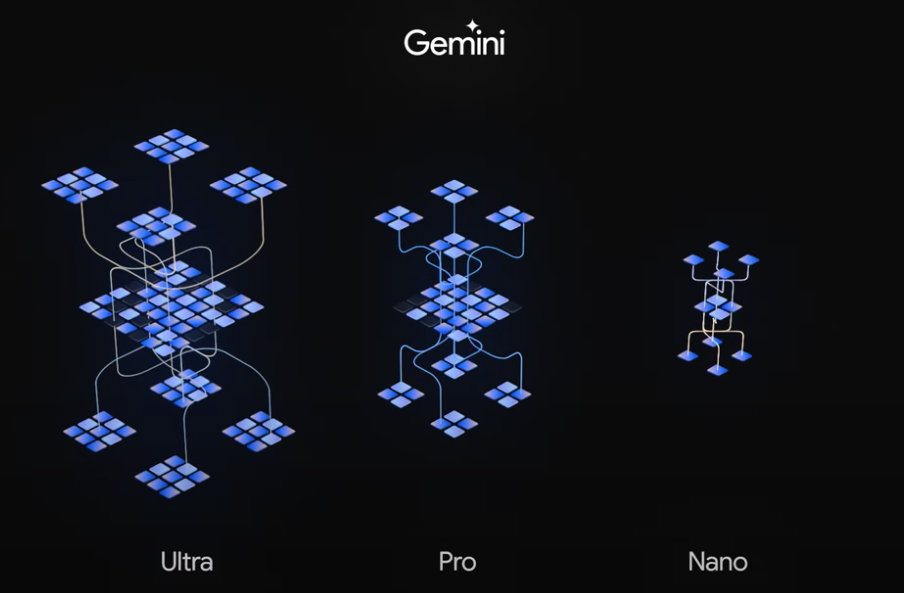

Gemini总共有三个版本:面对高度复杂任务的Gemini Ultra;用于一般多任务处理的Gemini Pro,以及应用于用户设备端侧的Gemini Nano。

Gemini Nano已经可以应用于谷歌的Pixel 8系列智能手机;Gemini Pro即日起支持AI聊天机器人Bard,下周面向云客户;最强大版Gemini Ultra明年推行,同时也可以支持Bard。

在32项行业大模型基准指标测试中,Gemini有30种“遥遥领先”GPT-4;Gemini为原生多模态模型,支持文本和图像的服务,速度更快、效率更高,在谷歌更高性能云芯片TPU v5p训练,谷歌搜索明年融入Gemini功能。

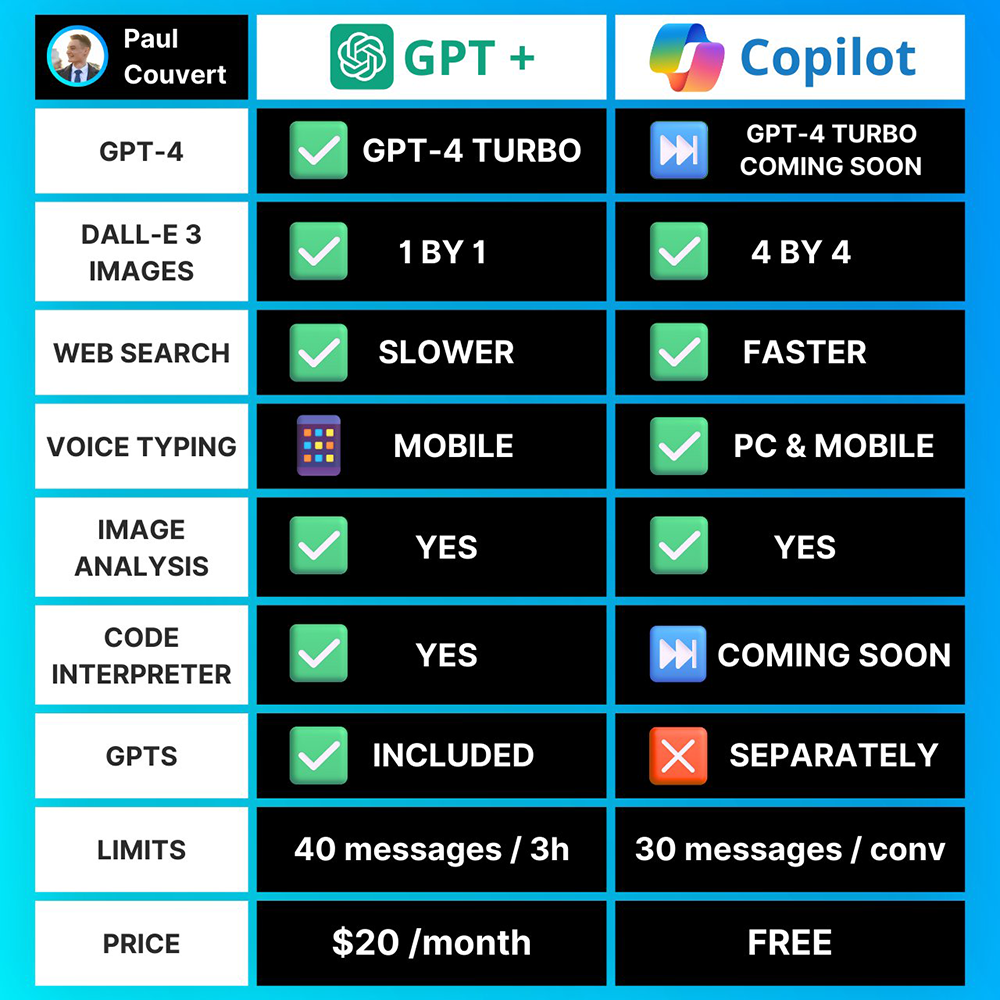

当地时间12月5日,微软旗下AI智能助手Copilot发布一周年之际,官方宣布迎来三项重磅更新,包括加载全新AI模型、新搜索以及代码解释器,图文能力、代码能力大幅升级。简单来说,就是ChatGPT Plus能干的活,升级后的Copilot几乎都能干,并且还免费。

此次更新,微软Copilot将支持OpenAI最新的GPT-4 Turbo模型,还将文生图模型DALL-E 3进行了全面升级,从而提供更高质量、更准确的图像。

搜索方面,Copilot推出两项新功能,分别从多模态、意图理解方面对搜索引擎进行加强。代码解释器目前推出简单版,能以自然语言生成代码,并支持在沙盒环境中运行,后续还将支持上传和下载文件。

最关键的是,微软Copilot财大气粗,依然向用户免费推出使用,这让每月订阅20美元的ChatGPT Plus显得有些缺乏性价比。

当地时间12月5日,苹果机器学习研究团队的Awni Hannun在GitHub提交了一份MLX机器学习框架的源代码,这是一个专为Apple Silicon芯片设计的高效机器学习框架,目前已开源。

据GitHub主页显示,MLX包括Python API、C++ API,具有用于自动微分、自动矢量化和计算图优化的可组合函数转换,采用惰性计算,动态构建计算图,支持多设备,并且统一内存。苹果还开源了MLX Data,这是一个与框架无关的、高效且灵活的数据加载包。

12月5日,美图公司发布AI视觉大模型MiracleVision的4.0版本,新增AI设计与AI视频两大能力。其中,AI设计具备四大功能,包括矢量图形、文字特效、智能分层和智能排版,可以满足AI设计的基础需求。MiracleVision4.0还上线了全新的视觉模型商店,提供多种风格的视觉模型。AI视频能力具备文生视频、图生视频、视频运镜、视频生视频四大功能,目前已能融入行业工作流,尤其是电商和广告。

MiracleVision4.0将于2024年1月陆续应用于美图秀秀、美颜相机、Wink、美图设计室、WHEE等美图旗下产品。同时,美图还宣布WHEE上线移动端,MiracleVision正式开放商业API,并提供3个阶梯套餐。

如果问一个AI模型开发程序员,圣诞节最想要什么礼物?他们的答案肯定是英伟达的GPU。

作为2023年最紧俏的AI硬件,英伟达的H100系列AI芯片已经被各大科技巨头瓜分殆尽。根据Omdia半导体研究最新公布的报告,微软和Facebook母公司Meta位居榜首,双双从英伟达购买了15万块H100 GPU。从第三名开始,购买数量开始断崖式下跌。谷歌、亚马逊和甲骨文等公司各抢到了5万块GPU。其中,谷歌通过自研的张量处理器单元弥补了一些外部购买AI芯片的需求。

中国科技巨头也是英伟达芯片的大客户,比如腾讯购买了5万块H800 GPU,百度和阿里巴巴分别购买了3万和2.5万块GPU。

值得注意的是,本次客户名单中并没有出现苹果的身影。

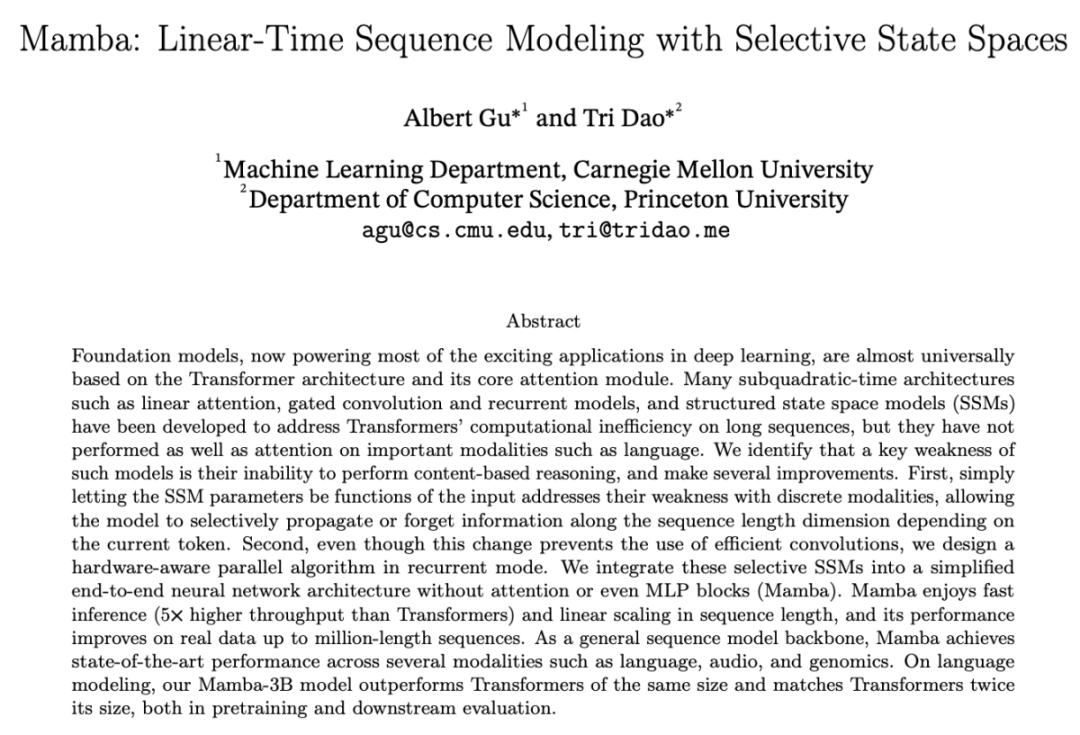

屏幕前的你,可能还不太熟悉AI大模型的工作原理,简单地说,现在主流的AI大模型都基于一种名叫Transformer的深度学习架构,这种架构在2017年首次以论文形式被世人所熟知。但是它也同样存在严重的短板——运算效率低下。

为了解决Transformer在长序列上的计算效率低下问题,卡内基梅隆大学和普林斯顿大学的研究者于12月1日提出了一种新架构Mamba(曼巴)。Mamba是一种状态空间模型(SSM),具有快速推理和序列长度的线性缩放优势,据称吞吐量比Transformer高5倍,并且在真实数据上处理长达百万长度的序列时性能有所提升。

作为一个通用的序列模型主要干,Mamba在语言、音频和基因组学等多种领域都实现了最先进的性能。在语言建模方面,Mamba-3B模型在预训练和下游评估方面都优于同等大小的Transformer,其性能甚至可与两倍大小的Transformer相媲美。