2023-11-10 09:21

2023-11-10 09:21

Stable Diffusion应用教程丨如何快速通过Stable Diffusion生成角色固定姿势?

本文主要分为两部分:

一、软件篇(如何搭建Stable Diffusion环境)

二、实战篇(如何完成一张立绘)

软件部分会为大家推荐一些B站优秀的UP主的教程,讲解的十分详细。

本文会先带大家了解模型、VAE和LORA这三个概念。而实战部分会以出草图 - 大量AI出图 - 局部修改(AI迭代)- 再次修改,这样一个过程。

前期需要准备:Stable Diffusion本地包、Stable Diffusion模型、VAE和LORA。

1.Stable Diffusion本地包

这里推荐秋叶的本地的Stable Diffusion包,视频在下方:

2.Stable Diffusion模型如何下载

https://civitai.com(点右上角眼睛可以开关18+模式)大多数模型都可以在C站找到,优先推荐在C站找,如果没找到,再去huggingface.com,它的资源相比更多一些,但使用起来没有C站方便。

3.模型如何选择

C站的好处是可以很直接看到效果图,网友的返图。甚至可以点开图片右下角的叹号,可以看到该图的大部分参数,可以直接复制到Stable Diffusion使用,大大方便了我们的作图流程。

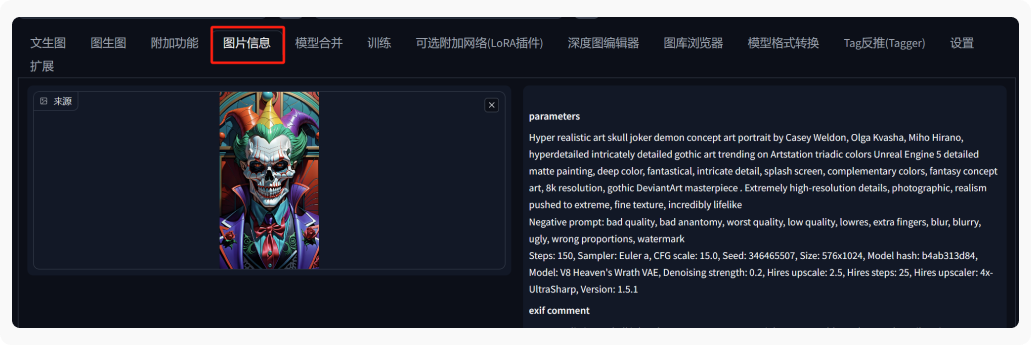

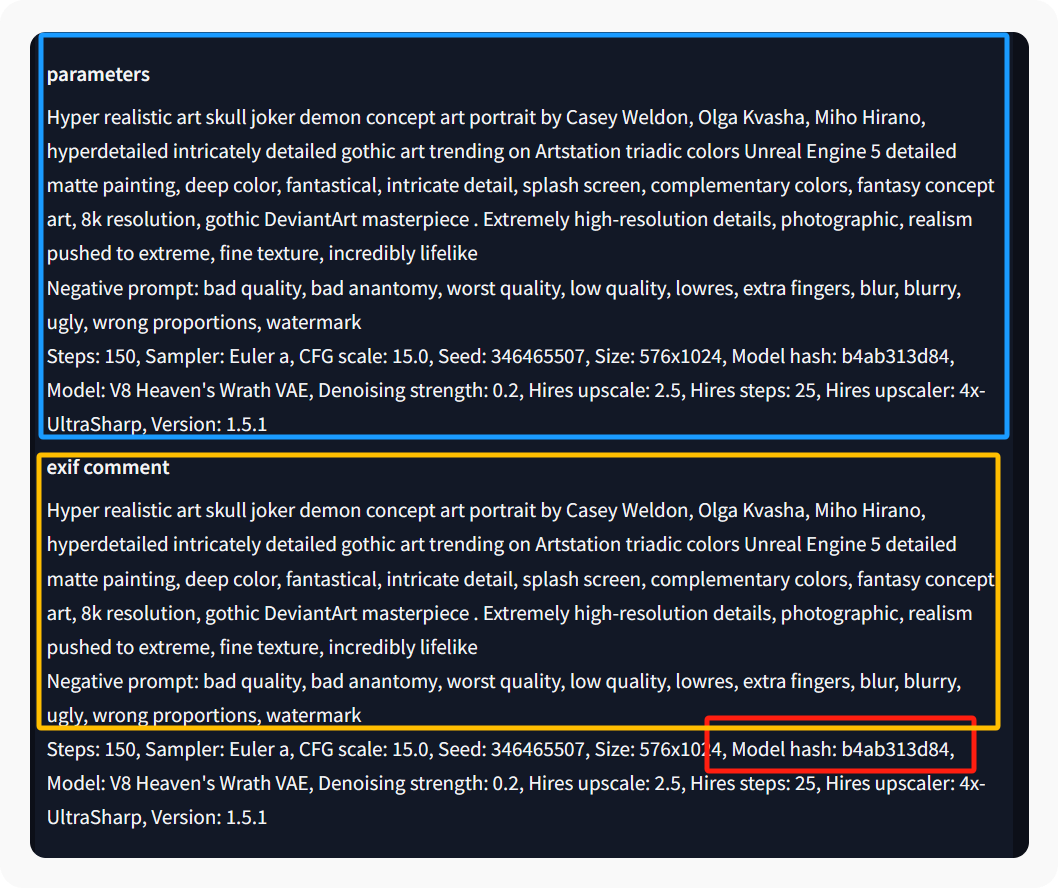

根据原图反向寻找模型。

打开Stable Diffusion,进入图片信息中,将原图拖入,在右侧就可以看到图片的全部信息。

蓝框是提示词,黄框是反向提示词,红框就是我们需要的模型哈希值(即模型编号)将这个编号输入到C站的搜索框中,即可根据原图反向找到模型。

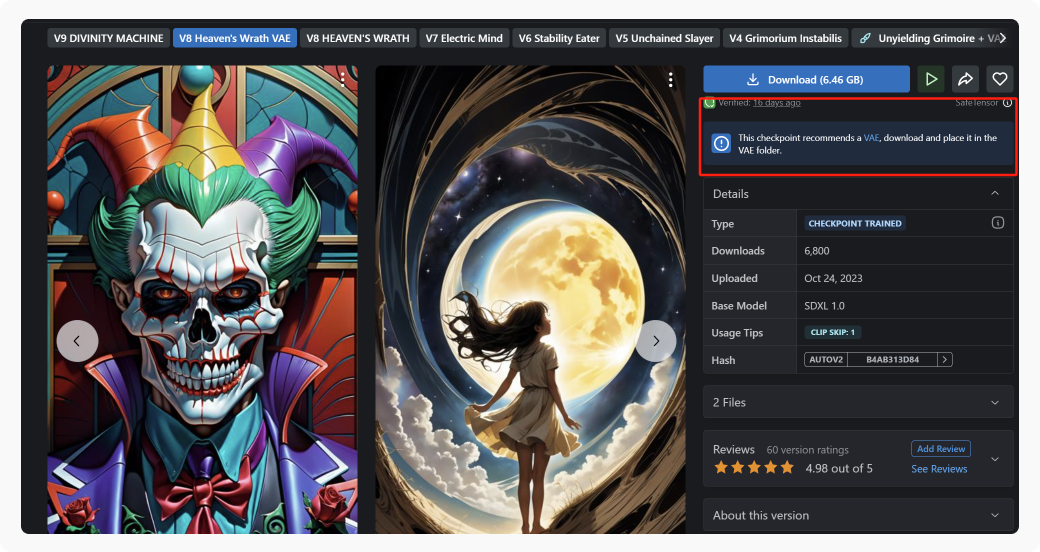

4.模型VAE

VAE用于增强画面的颜色信息,如果你感觉画面发灰,大多是因为VAE的问题导致。大多数模型都会提供VAE的下载。(如下图红框)若没有VAE的显示,一般使用默认的 { final-prune.vae }

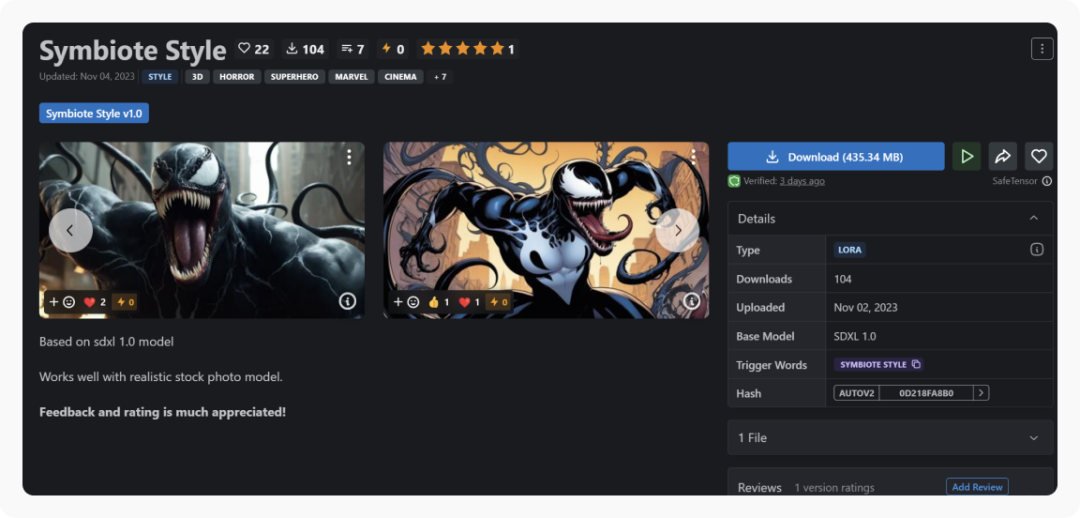

5.LORA是什么

LORA是用于稳定你的画面元素,例如想让画面出现特定的人物,武器,穿着等,都需要使用相对于的LORA。可以把LORA理解为稳定你画面的某种元素。

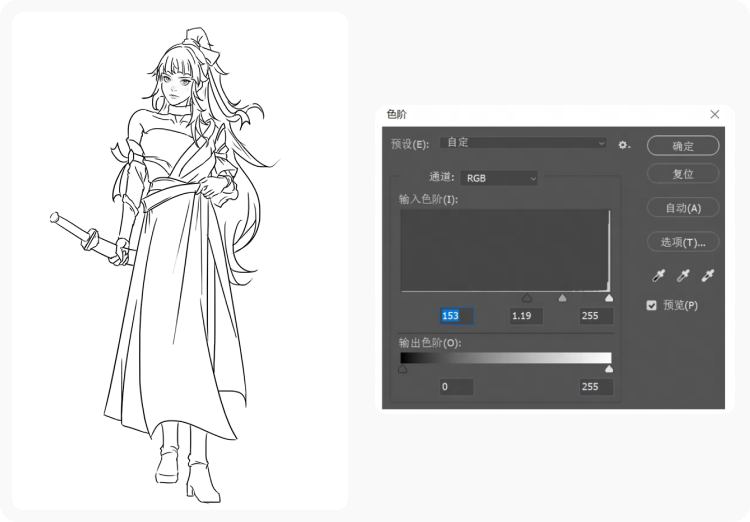

1.草图绘制

这里要注意的点是把你需要的动作和造型尽量勾勒清楚,并且线条要足够深度和足够清晰,不然Stable Diffusion是识别不出来的。这里我们可以通过PS中的色阶选项将线稿进行拉深。

2.关键词

关键词分为正面,负面两种关键词。正面关键词内容我们可以分为头部,上半身,四肢等逐一表述,较为清晰。把想要的动作(比如手拿着剑),衣服的材质颜色等一一说明,重要内容可以加上括号强调权重。

最后加上一些画面以及风格的补充词(独奏,最高质量,逼真等)。因为模型已经确定了风格,我们不需要加过多的一些风格上的描述词。

而反面关键词则是你不想画面出现的内容,这里分享一组比较万能的负面关键词:(bad-artist:1.0), (loli:1.2), (worst quality, low quality:1.4), (bad_prompt_version2:0.8), bad-hands-5.lowres, bad anatomy, bad hands, ((text)), (watermark), error, missing fingers, extra digit, fewer digits, cropped, worst quality, low quality, normal quality, ((username)), blurry, (extra limbs),

3.生成设置

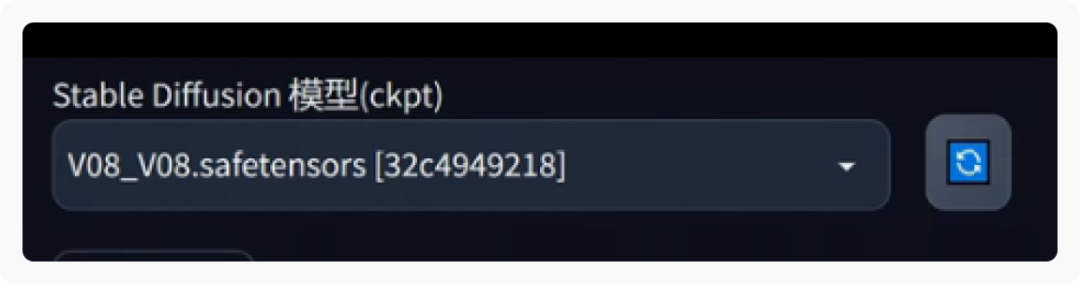

我们将生成好的描述词复制进去,点击LOAR模型,点选想要的模型,在正面描述词里就会自动生成一条关于LORA的关键词,将词组最后的数字1改为0.5.降低其权重。

左上方菜单下拉选择需要的模型,本次使用的是国风三大模型,采样器选择DPM++ Stable DiffusionE Karras,采用步数选择30.生成批次选择6

4.Control Net设置及应用

页面滑动至下方点选Control Net选项,将线稿拖入其中,点击启用,点选后面的Pixel Penfect(像素完美),再选择Allow Preivew,选择Lineart这条比较长的选项和相对应的模型。

在Stable Diffusion新版本中这里会有直接可以选择的选项,直接选择Lineart的选项就好。(注:这里需要下载相对于的Control Net的模型)

点击爆炸小图标,我们就可以看到相对于的生成的线稿了。点击预览图下方的小箭头,线稿的尺寸分辨率就相对于配置上去了。

5.批量生成

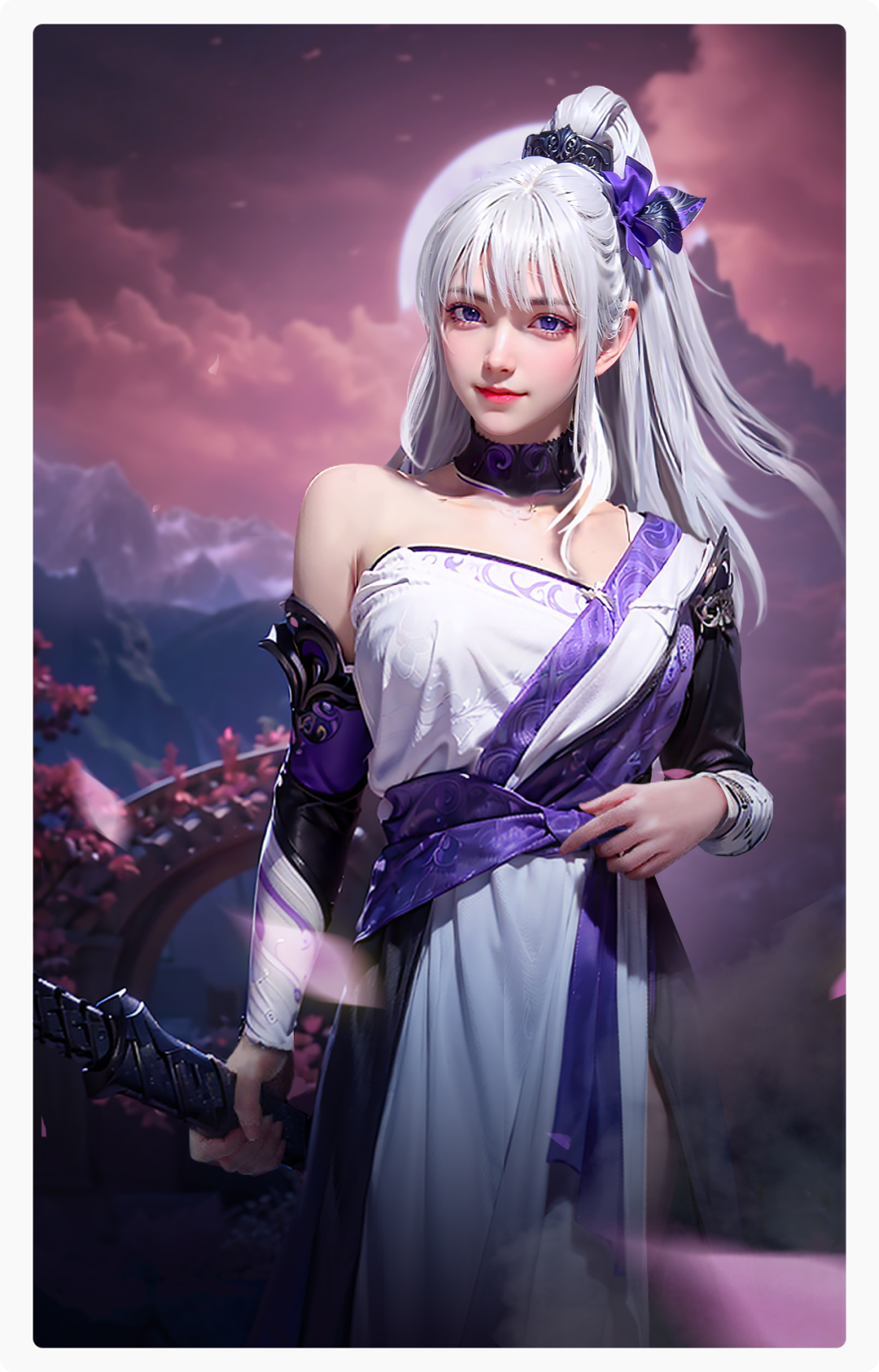

点击生成开始批量运算。这里我尝试了一下不同的大模型来生成不同的风格。

这里我们可以看到,通过Control Net的Lineart,可以很好的识别到我们草图的动作姿势和衣服造型等,我们可以选择一张较为满意的进行下一步操作。

注:如果电脑配置比较低,可以先将草图压缩下尺寸再拉进来识别线稿,这一步我们主要还是找整体画面的大感觉,对于画面模糊或者局部的BUG不用特别注意,会在下面的操作中进行细化补救。

6.图生图

接下来选择一张我们相对比较满意的图,点击预览下方的图生图按钮进入,进入后可以看到我们相对应的参数都已经自动配置上来了,这里我们需要再做的是重新选择我们的采样器DPM++ Stable DiffusionE Karras,接着将高度和宽度放大,重绘幅度建议控制在0.4.采样步数可以适当提高一些,30-50左右,点击生成,进行下一步的精细化生成。

注:如果电脑配置比较低,高度和宽度就不要一次拉太高。

这里我将画面精细化生成后,又在PS中调整了一下并裁切了一些需要更多的细节的地方再进行放大重新生成。

7.细化

最后我们可以重点调整下脸部刻画,这里推荐一个插件Face Editor,他可以有效修缮脸部崩坏,头发奇怪等。然后再在PS中将BUG优化。

例如手部结构出错等,我们可以顺着AI生成的图像进行优化,或者制作深度图再次进入AI进一步生成,这里因人而异,采取最适合自己的方法就好。并调整下画面光影和整体氛围,因为这里只是作为一个小案例,就大概修缮了一下。

可以看到,整体动作和衣服相对于草图的还原度还是比较高的。通过Control Net的Lineart,我们可以精准控制画面人物的动态衣服,使其更符合我们的需求。

以上就是如何快速通过Stable Diffusion生成角色固定姿势,如果你有其他快速方法,欢迎在评论区留言。

近期文章

更多